Vivimos inmersos en la era de la inteligencia artificial (IA) y ello, sin lugar a dudas, reporta muchos beneficios y ventajas a la sociedad y a las organizaciones, aunque también plantea importantes desafíos y riesgos legales, por las implicaciones que esta tecnología tiene sobre los derechos fundamentales de las personas, incluyendo, la protección de los datos personales cuando estos se tratan por relación a un sistema de IA. Algo que no debe pasar desapercibido en el Día de la Protección de los Datos.

Es importante destacar que un sistema de IA podría no formar parte de un tratamiento de datos personales. Por ejemplo, un sistema de IA operando en un entorno de producción industrial, como podría ser en una cadena de montaje, en el que no se han utilizado datos personales para su desarrollo y que no tiene ninguna interacción o decisión en relación con operadores humanos no estaría afectado por el alcance del Reglamento General de Protección de Datos (RGPD). Ahora bien, sí existen diversos tratamientos RGPD en los que podrían estar involucrados uno o varios sistemas de IA. De hecho, un sistema de IA se puede encontrar en el marco de cuatro grupos de tratamiento de datos: diseño/desarrollo, distribución, operación y evolución. Cada uno de ellos podría implicar distintos responsables e implicaciones legales.

Pues bien, cuando existe tratamiento de datos personales en el marco de los sistemas de IA, el Supervisor Europeo de Protección de Datos (EDPS), en su reciente Opinión 44/2023, sobre la propuesta de Reglamento europeo de Inteligencia Artificial es muy claro acerca de tales desafíos al indicar que la IA con sus características específicas (por ejemplo, opacidad, complejidad, dependencia de datos, autonomía) puede afectar negativamente a la privacidad.

De hecho, entre los requisitos más importantes para garantizar una IA Confiable (TrustedAI) se sitúa, según la UE, la gestión de la privacidad y de los datos[1]. Y es que la privacidad es un derecho fundamental que se ve especialmente afectado por tales sistemas, lo que guarda una estrecha relación con el principio de prevención del daño que, a su vez, requiere de una adecuada gestión de los datos, incluyendo la calidad y la integridad de estos, su pertinencia, sus protocolos de acceso y la capacidad para procesar datos sin vulnerar este derecho fundamental. Algo que ha puesto especialmente de relieve la última versión acordada del Reglamento de Inteligencia Artificial (ex Considerando 14a de la Propuesta del Reglamento de IA (RIA)).

La RIA, en particular, pone el acento en determinados casos de uso específicos por relación a la privacidad, por ejemplo, respecto a la protección de las personas ante los nuevos sistemas de reconocimiento facial de corte masivo (Considerando 26b de la RIA), o respecto a los mecanismos de control laboral que puedan resultar desproporcionados o excesivos en los centros de trabajo (considerando 36 de la RIA), entre otros.

El Considerando 45a de la RIA, en particular, insiste en la necesidad de que la protección de datos personales debe garantizarse durante todo el ciclo de vida de los sistemas de IA, con especial atención a los principios de minimización de datos y de privacidad desde el diseño y por defecto, de forma que los proveedores de estos sistemas deben adoptar medidas adecuadas al respecto, por ejemplo, la anonimización y la encriptación de los datos personales afectados.

Por su parte, la Agencia Española de Protección de Datos (AEPD), al igual que otros reguladores europeos, ha tenido ocasión de pronunciarse en múltiples ocasiones sobre estos temas, a través de diferentes publicaciones y guías. Estas abordan diversos aspectos del ciclo de vida de los datos a través de los sistemas de inteligencia artificial y sus etapas (concepción y análisis, en la que se fijan los requisitos funcionales y no funcionales de la solución IA; desarrollo del sistema, incluyendo etapas de investigación, prototipado, diseño, pruebas, entrenamiento y validación; explotación, que comprende la ejecución de distintas acciones, y algunas de ellas se ejecutarán en paralelo: integración, producción, despliegue, inferencia, decisión, mantenimiento y evolución; y la retirada final del tratamiento/componente).

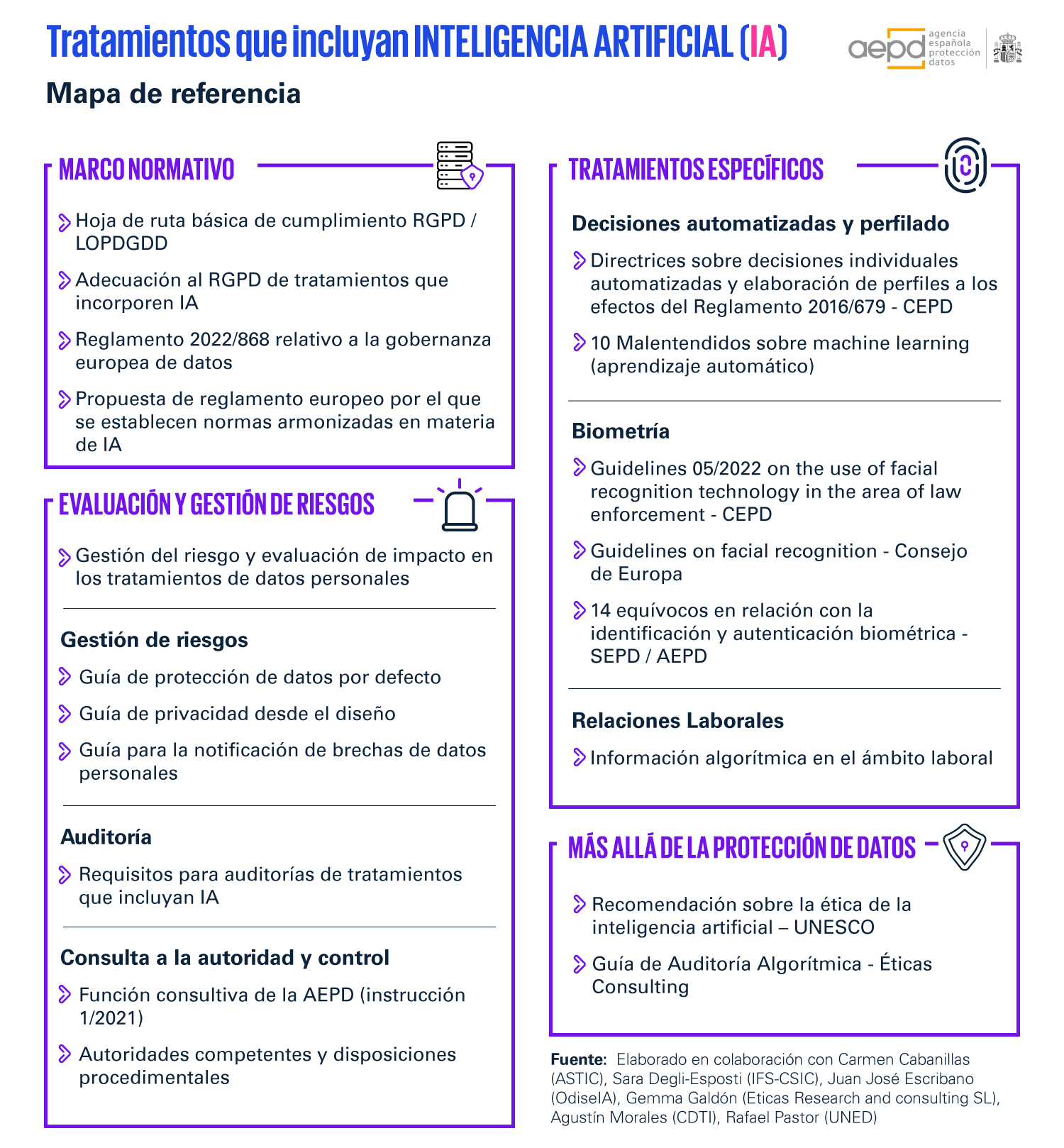

De hecho, es interesante considerar al efecto el Mapa de referencia que la AEPD ha publicado por relación a las actividades de tratamiento que incluyan IA, como orientación general:

En tal sentido, atendiendo a las principales directrices y recomendaciones emitidas por parte de las autoridades de control competentes, se pueden extraer las siguientes consideraciones para tratar de acertar en el establecimiento de un modelo de la protección legal coherente en este ámbito, a saber:

Los sistemas de IA deben desplegarse en coherencia con las políticas de privacidad desde el diseño y por defecto que hayan establecido las organizaciones, algo a lo que vienen abocadas en virtud del artículo 25 del RGPD. Asimismo, esto se conecta con el principio general de diseño legal de productos y servicios en el entorno digital reconocido en la Carta de Derechos Digitales española.

Tanto el modelo de IA incluido en un tratamiento de datos, como el tratamiento en sí, han de tener el propósito de dar respuesta a una necesidad real de la empresa y la industria (uso de datos personales con un propósito (objetivo) claramente definido) y, además, responder a bases legales (principio de legitimación). Por tanto, la legitimación para las distintas etapas del ciclo de vida y para cada tratamiento se tiene que establecer en la fase de concepción del tratamiento de datos que incluya IA.

Además, una base jurídica no habilita para el uso de los datos para cualquier propósito y en todo momento, debiendo restringirse a aquellos fines determinados, explícitos y legítimos que se hayan identificado, evitando tratarlos de manera incompatible con esos fines.

Esto último se puede observar de forma clara, por ejemplo, respecto a la constitución de conjuntos de datos. Y es que existen dos opciones principales para la constitución de conjuntos de datos, la recogida específica de datos personales para este fin y la reutilización de datos ya recopilados para otro fin. En este último caso, se plantea, de hecho, la cuestión de si los fines para los que se recogieron inicialmente los datos son compatibles (o no) con las condiciones en las que se ha constituido el conjunto de datos inicial.

En todo caso, dependiendo de la base seleccionada, las obligaciones legales de la organización y los derechos de los individuos pueden variar.

La información que cada responsable del tratamiento ha de proporcionar a los interesados se establece en los artículos 13 y 14 del RGPD y demás normativa concordante, y el contenido concreto de la misma se tendrá que adaptar a la concreta etapa del ciclo de vida de la IA en la que se esté realizando el tratamiento de datos en cuestión.

Ahora bien, como bien matiza la AEPD, se debe distinguir entre la transparencia a la que alude RIA y la transparencia a la que se refiere el RGPD. La Transparencia de la RIA impone obligaciones aplicables desde el diseño del sistema de IA y a lo largo de todo su ciclo de vida, independientemente de si procesan datos personales. Por lo tanto, el término «transparencia» en la RIA (Transparencia-RIA) se utiliza con un significado diferente al de Transparencia en el RGPD. La Transparencia-RIA obliga a diseñadores, desarrolladores, proveedores y usuarios/entidades que despliegan sistemas de IA. En cambio, Transparencia-RGPD obliga a los responsables del tratamiento. Los diseñadores y desarrolladores pueden ser responsables o encargados del tratamiento si utilizan datos personales en el diseño o desarrollo del sistema de IA. Los proveedores pueden ser responsables o encargados del tratamiento si los sistemas de IA almacenan o tratan datos de interesados identificados o identificables. Los usuarios/entidades que despliegan un sistema de IA podrían ser responsables o encargados del tratamiento si incluyen dicho sistema como parte de sus tratamientos. Únicamente aquellos que actúen como responsables del tratamiento deben cumplir las obligaciones de Transparencia-RGPD.

En el caso de que el interesado esté sometido a decisiones automatizadas o en la elaboración de perfiles a los que hace referencia el artículo 22 del RGPD, un aspecto importante que se establece en el artículo 13.2.f) del RGPD es que éste ha de disponer de información significativa sobre la lógica aplicada y la importancia y las consecuencias previstas.

Este derecho de información algorítmica, de hecho, se ha concretado a nivel laboral a través del artículo 64.4 d) del Estatuto de los Trabajadores que dispone que el Comité de Empresa tendrá derecho a ser informado por la empresa de los parámetros, reglas e instrucciones en los que se basan los algoritmos o sistemas de inteligencia artificial que afectan a la toma de decisiones que pueden incidir en las condiciones de trabajo, el acceso y mantenimiento del empleo, incluida la elaboración de perfiles. En este ámbito, existe un Manual publicado por el Ministerio de Trabajo que desarrolla como cumplir con esta nueva obligación laboral.

La minimización persigue optimizar el tratamiento desde el punto de vista de la protección de datos, analizando las necesidades de proceso de datos en las distintas fases. Por ejemplo, desde la propia concepción del sistema de IA es necesario balancear la necesidad de datos para el entrenamiento de los sistemas con los riesgos para los derechos y libertades de los interesados.

La existencia de sesgos en los modelos de inferencia está íntimamente relacionada con la exactitud o calidad del dato. Garantizar la calidad de los datos es un elemento absolutamente crucial en la RIA para garantizar la protección de los derechos fundamentales.

Los responsables del tratamiento que hagan uso de soluciones o sistemas de IA para tratar datos personales, elaborar perfiles o tomar decisiones automatizadas, han de garantizar el pleno ejercicio de los derechos de las personas afectadas, estableciendo los mecanismos y procedimientos adecuados para poder atender las solicitudes que reciban.

Tanto la RIA como el RGPD aplican un enfoque de riesgo, por lo que evaluar durante todo el ciclo de vida del sistema de IA los riesgos asociados resulta clave para poder cumplir con tales normativas.

En el caso del tratamiento de datos de carácter personal, es importante cuando se aplican tecnologías emergentes como IA realizar una evaluación de impacto en materia de protección de datos personales (obligatorio en los casos a los que alude el artículo 35 del RGPD). Además, si nos atenemos a las recientes recomendaciones de las autoridades de control, y el contenido actual de la RIA, incluso, estas evaluaciones deberían tornarse en evaluaciones más amplias relativas al impacto de tales sistemas en los derechos fundamentales, más allá de la mera privacidad algo que, resultará exigible, como mínimo, para aquellos sistemas calificados como de alto riesgo, según la RIA.

Según la AEPD, en los distintos tratamientos en los que se encuentre involucrado un sistema de IA habrá que realizar una gestión del riesgo atendiendo no solo a la naturaleza de alguna de sus operaciones (uno o varios sistemas de IA), sino que habrá que tener adicionalmente en cuenta el riesgo para los derechos y libertades que implican el uso conjunto de todos los sistemas que implementan el tratamiento, el ámbito o extensión de dicho tratamiento, el contexto en el que se desenvuelve y los fines, así como la incertidumbre que puede introducir el uso de nuevas tecnologías.

Existen ciertos riesgos a los que habrá que atender de forma especial como, por ejemplo, los riesgos inherentes al aprendizaje continuo (supervisión de la mejora continua) donde los datos utilizados durante la fase de producción también se utilizan para mejorar el sistema, creando así un circuito de retroalimentación.

Al respecto, el Delegado de Protección de Datos (DPD) es un elemento clave para garantizar el cumplimiento y la gestión del riesgo para los derechos y libertades de los interesados, y puede ser de gran utilidad en aquellas entidades que usan sistemas IA y que tratan datos personales, o que desarrollen soluciones de IA que implican el tratamiento de este tipo de datos, al ser considerado un elemento que permite demostrar responsabilidad proactiva en las organizaciones.

El RGPD establece en su artículo 32 que tanto el responsable como el encargado del tratamiento, aplicarán medidas técnicas y organizativas apropiadas para garantizar un nivel de seguridad adecuado al riesgo para los derechos y libertades de los interesados. Estas medidas se adecuarán a los costes de aplicación, la naturaleza, el alcance, el contexto y los fines del tratamiento, así como a los riesgos de probabilidad y gravedad variables, lo que se podrá determinar en los propios análisis de riesgos que se realicen al efecto.

Los datos personales no se pueden conservar indefinidamente. El RGPD exige que se especifique un límite de tiempo más allá del cual los datos deben eliminarse o, en algunos casos, archivarse. Este plazo de conservación deberá ser determinado por el responsable del tratamiento en función del objetivo para el que se recogieron los datos y según la ley aplicable.

Según la AEPD, es importante realizar auditorías para determinar la adecuación a las exigencias del RGPD y comprobar la validez del tratamiento basado en soluciones de IA. Para ello puede ser interesante acudir a las recomendaciones publicadas por esta autoridad de control al efecto.

En definitiva, la IA implica un nuevo paradigma respecto a la privacidad sobre las que las organizaciones deberán reflexionar y trabajar, en base a los específicos casos de uso y sistemas que pretendan desplegar o desarrollar, para adaptar sus actuales modelos y marcos de gestión de riesgos mitigando estos al máximo posible.

Deja un comentario